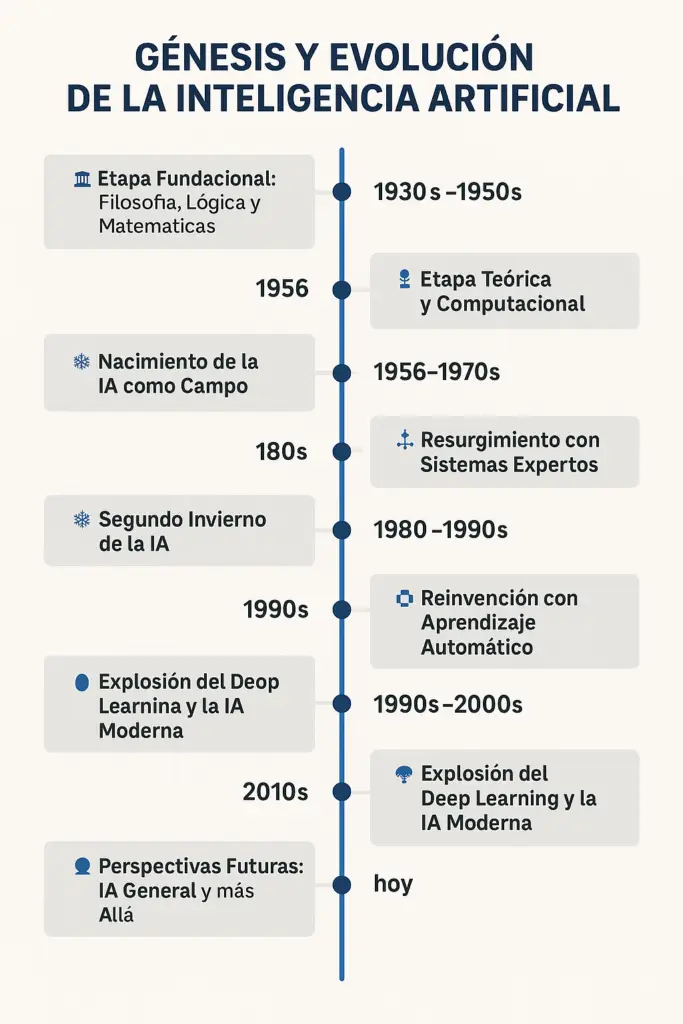

La inteligencia artificial génesis y evolución tiene sus raíces mucho antes de la era digital, en el pensamiento filosófico y matemático de la antigüedad. Filósofos como Aristóteles ya hablaban de razonamientos lógicos formales, y en el siglo XVII, Leibniz soñaba con una “lengua universal” que pudiera representar todo el conocimiento humano mediante símbolos manipulables lógicamente. Este tipo de pensamiento, centrado en la formalización del razonamiento, sentó las bases para lo que más adelante sería la IA.

Siglo XIX

Charles Babbage diseñó la primera máquina programable, la “máquina analítica”, y Ada Lovelace escribió el primer algoritmo para ejecutarse en ella, anticipando la programación. Estas ideas y avances marcaron el inicio de una larga búsqueda: reproducir la inteligencia mediante medios mecánicos o formales.

Siglo XX

El trabajo de Alan Turing en los años 30 fue clave. En 1936 propuso la “máquina de Turing”, un modelo teórico de computación universal que sentó las bases de la informática moderna. Más adelante, en 1950, publicó el artículo “Computing Machinery and Intelligence”, donde planteó la célebre pregunta “¿Pueden las máquinas pensar?” y propuso lo que hoy conocemos como el Test de Turing. Paralelamente, surgía la cibernética de Norbert Wiener, que exploraba el control y la comunicación en sistemas vivos y artificiales. Con el desarrollo de las primeras computadoras electrónicas en los años 40 y 50, se abrió la puerta para poner a prueba estas ideas en la práctica.

Nacimiento formal de la IA

El nacimiento formal de la inteligencia artificial como disciplina ocurrió en 1956, en la conferencia de Dartmouth, donde John McCarthy (quien acuñó el término “Artificial Intelligence”), Marvin Minsky, Allen Newell y Herbert Simon propusieron estudiar cómo construir máquinas que pudieran razonar, aprender y resolver problemas como lo haría un ser humano. Este periodo inicial vio la creación de programas que podían jugar ajedrez o resolver teoremas matemáticos, como el Logic Theorist o el <>General Problem Solver, que usaban técnicas de razonamiento lógico. Aunque prometedores, estos sistemas eran limitados, ya que dependían de reglas explícitas creadas por humanos y tenían dificultades para enfrentar situaciones imprevistas.

Década del 60 y del 70

Durante las décadas de 1960 y 1970, el entusiasmo por la IA creció, pero también se enfrentaron a grandes obstáculos técnicos. La limitada capacidad de cómputo de la época y la complejidad de representar el conocimiento humano provocaron un estancamiento conocido como el primer invierno de la IA. Las promesas incumplidas llevaron a recortes de financiamiento y escepticismo entre científicos e inversionistas. Sin embargo, en los años 80, la IA resurgió con fuerza gracias a los llamados sistemas expertos: programas que codificaban el conocimiento de expertos humanos en reglas lógicas. Estos sistemas demostraron ser útiles en campos como la medicina (como el sistema MYCIN), y despertaron un renovado interés en aplicaciones prácticas de la IA.

Sistemas expertos

A pesar de este auge, los sistemas expertos mostraron pronto sus limitaciones. Eran difíciles de mantener y no podían aprender de nuevas experiencias, lo que provocó un segundo invierno de la IA hacia fines de los 80 e inicios de los 90. En respuesta, comenzó a crecer el enfoque del aprendizaje automático (machine learning), que propone que los sistemas no sean programados explícitamente para cada tarea, sino que aprendan patrones a partir de datos. Esto llevó al desarrollo de algoritmos como árboles de decisión, redes bayesianas y máquinas de soporte vectorial. Un hito importante fue en 1997, cuando la computadora Deep Blue de IBM venció al campeón mundial de ajedrez Garry Kasparov, marcando un avance significativo en el uso de IA en problemas complejos.

Siglo XXI

Ya en los años 2000, el crecimiento exponencial de los datos digitales (Big Data), el abaratamiento del hardware y la aparición de unidades de procesamiento gráfico (GPUs) permitió entrenar modelos más complejos y potentes. Así surgió el campo del aprendizaje profundo (deep learning), basado en redes neuronales artificiales de múltiples capas. En 2012, el modelo AlexNet revolucionó la visión por computadora al ganar el concurso ImageNet, reduciendo drásticamente el error en reconocimiento de imágenes. Luego vinieron desarrollos aún más impactantes: en 2016, AlphaGo venció al campeón mundial del juego Go, un desafío considerado inalcanzable para las máquinas hasta entonces.

Actualidad

Desde entonces, la IA ha evolucionado de forma vertiginosa. Se han desarrollado modelos generativos como GPT (Generative Pre-trained Transformer) de OpenAI, capaces de generar textos, responder preguntas, escribir código, componer música o generar imágenes a partir de descripciones. Estas IA modernas, conocidas como IA generativa, han democratizado el acceso a herramientas creativas, han transformado el trabajo en múltiples sectores y han puesto en marcha una profunda discusión ética y social sobre sus límites, riesgos y potencial.

El futuro…

Finalmente, el futuro de la IA se centra en varias direcciones: el desarrollo de una IA general (AGI) que sea capaz de realizar cualquier tarea cognitiva, como lo haría un humano; la creación de IA explicable para entender por qué una máquina toma determinadas decisiones; y el avance hacia sistemas que integren el conocimiento simbólico (lógico) con el aprendizaje estadístico. También están en el horizonte la regulación legal, los derechos digitales, la ética en el diseño y uso de IA, y la adaptación social frente al impacto laboral y cultural de estas tecnologías. Aunque aún estamos lejos de una inteligencia artificial con conciencia o emociones, cada paso técnico acerca más la posibilidad de máquinas verdaderamente autónomas y adaptativas.